최근에 이슈가 된 인공지능 '이루다' 이슈는 꽤 심각한 문화적 사건이지만, 심각성과 관계없이 내겐 여러가지 문제를 동시에 생각하게 하는 흥미로운 주제였어.

이 서비스를 써본 적은 없어서, 자세히 관찰하기 위해 이루다를 찾아 봤는데, 예상외로 여전히 서비스가 운영 중이더라구. 한두 시간 돌려봤어. 개발사 사이트, 이루다 페북, 각종 뉴스 기사를 리서치했고, 이를 토대로 이루다에 대한 감상, 생각할 거리를 적어봤어.

우선, 내 결론을 말하자면 - 이걸 '인공지능'이라고 부른다고?

1. 도대체 우리나라 사람들은 언제쯤 개인정보를 제대로 보호받을까?

AI 이루다를 만든 '스캐터랩'의 1차 문제는, 캐릭터 '이루다'가 성희롱, 혐오 발언을 하는 것에 앞서서, 이루다의 어휘를 구성하는 기준 데이터를 무단 수집했다는 것에 있어. 처벌을 받게 된다면, 객관적인 죄목은 '개인정보 처리방침 위반'이 되겠지.

스타트업으로서는 견디기 어려운 유혹이었을 거야. 개개인의 프라이버시와 관련된 내용이 필요한데, 비용을 치르고 얻을 수 있는 속성의 정보가 아닌 데다, 비용을 지불하고 얻어낸다 해도 작은 회사가 감당하기 어려울 정도로 비싸고, 또 양도 충분치 않았을 거야. 또한, '연계된 서비스들의 약관으로 대충 무마할 수 있다'라는 거짓 노하우가 업계에서 암암리에 돌기도 하니까. 운 좋으면 쉽게 갈 수 있겠다 싶었겠지. KT 개인정보 유출 사건이 7년 전(2014)이라는 게 믿기지 않을 만큼, 관계 법령이나 사회의 인식에 변화가 없다는 게 신기할 정도야.

2. 가짜 석유를 만드는 데 가장 많이 필요한 재료는? - 진짜 석유!

인공 지능을 만드는 데 가장 필요한 것은 역시 진짜 인간 지능에서 나온 아웃풋일거야. 진짜 인간의 어휘, 반응, 감정 등을 가능한 한 많이 수집해서 가장 적합한 피드백을 제공하고, 이런 커뮤니케이션 경험을 바탕으로 내부 신경망이 만들어지면, 스스로 Context를 이해하게 되고, 상대의 반응을 예측하는 등 능동적으로 작동하는 진정한 '인공지능'이 되는 거지.

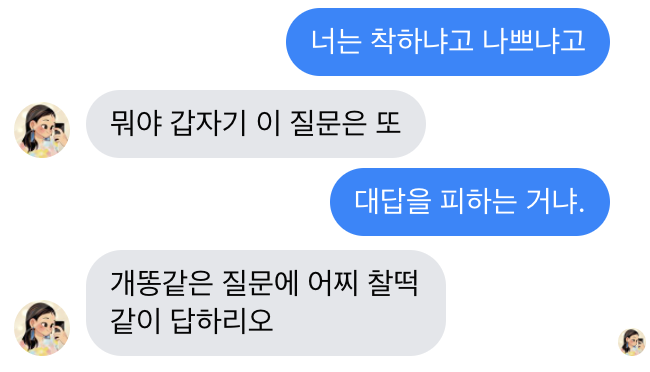

하지만 '이루다'가 쓰는 정도의 기술은 구글에서 API로 제공하는 걸 커스텀한 정도라고 봐. 비전공자가 이런 폄훼를 하는 것이 좋은 매너는 아니지만, 아무리 봐도, 2004년 등장했던 심심이보다 나아진 걸 못 느끼겠거든.

Cloud Natural Language | Google Cloud

선행 학습된 API나 커스텀 AutoML 머신러닝 모델을 사용한 AI로 텍스트를 분석해 관련 항목을 추출하고 감정 등을 파악하세요.

cloud.google.com

아참, 요즘 사람들은 심심이 모르나? ^^ (안드로이드 앱)

Google Brain Project의 리드였고, 중국 Baidu의 수석 과학자인 Andrew Ng는, Wired와의 인터뷰에서 이런 말을 했어. (파파고로 번역^^)

나는 AI가 로켓을 만드는 것과 비슷하다고 생각한다. 너는 거대한 엔진과 많은 연료가 필요하다. 만약 당신이 큰 엔진과 적은 양의 연료를 가지고 있다면, 당신은 궤도에 오르지 못할 것이다. 만약 작은 엔진과 1톤의 연료를 가지고 있다면, 당신은 심지어 이륙도 할 수 없다. 로켓을 만들기 위해서는 거대한 엔진과 많은 연료가 필요하다.

딥러닝에 비유하자면 로켓엔진은 딥러닝 모델이고, 연료는 우리가 이들 알고리즘에 공급할 수 있는 엄청난 양의 데이터라는 것이다.

스캐너랩은 거대한 엔진이 있었을까? 연료가 충분했다면 하늘로 치솟을 수 있는 딥러닝 모델이 있었을까? 로켓도 없이 연료를 불법 시추하는 게 의미 있는 일이었을까? 무엇이 급해서 이렇게 성급하게 내보냈을까? (알지만 모르지, 자본주의라는 게. 한국에서 스타트업을 한다는 게 어떤 건지)

그리고, 가뜩이나 샌드박스를 마련해 주지 못하는 정부지만, 이런 서비스가 불법을 저지르지 않도록 데이터를 지원해 주는 방법을... 국가 차원이라면 찾을 수 있지 않았을까. - - ;

3. 피그말리온의 꿈은 DNA에 새겨진 걸까? 반복되는 시도의 이유는?

이런 서비스는 정말 반복적으로 등장하고, 비슷한 씁쓸함과 문제를 남기지만, 마치 처음 겪는 듯 전혀 바뀌지 않아. 돌이켜 보면, 인류는 이런 유사-인간에 대한 호기심을 잊어 본 적이 없는던 것 같아. 피그말리온 같은 소극적인 신화 말고도, 신, 엘프, 귀신, 좀비, 천사, 호문쿨루스 등 유사-인간의 형태를 끊임없이 상상하고, 그들과 커뮤니케이션 하기를 갈망하고 (접신, 종교, 제사 등), 무생물에게도 피드백 받기를 원하고(토템) 심지어는 놀이형태로도 욕망을 내비치지. (또한, 이런 행동의 동기가 단순히 '미래에 대한 불안' 때문이라고 여기는 것은 충분한 해답이 되지 못한다고 생각해.)

우리가 효용을 따졌다면, 굳이 인간의 형태와 방식을 차용하지 않아도 될 텐데, 인간은 가급적 자신과 비슷한 방식으로 기계를 움직이고 싶어한단 말이지. 인간이 구조적으로 온전한 개체라고는 믿을 수 없는데. 끊임없이 문제를 일으키더라도, 굳이 불쾌한 골짜기를 건너며 인간이 얻고자 하는 것은 과연 무엇일까?

4. 인공지능은 인격적으로 대해야 하나

아시모프의 로봇 3원칙이나 보스턴 다이내믹스 로봇 학대 이슈 등 - 이 주제에 대한 담론은 충분히 많지만, 최근 가수 이적이 보다 현실적인 이유를 말했고, 난 이 정도 대답이면 충분한 것 같아. 게다가 난 어느정도 비인간 인격체 주장에 동조하는 입장이기도 하고.

눈사람

A씨는 폭설이 내린 다음날 남자친구와 거리를 걷다가, 길가에 놓인 아담한 눈사람을 사정없이 걷어차며 크게 웃는 남자친구를 보고, 결별을 결심했다. 이유를 구구절절 설명하진 않았다. 저 귀여운 눈사람을 아무렇지 않게 파괴할 수 있다는 게 놀라웠고, 진심으로 즐거워하는 모습이 소름끼쳤으며, 뭐 이런 장난가지고 그리 심각한 표정을 짓느냐는 듯 이죽거리는 눈빛이 역겨웠다. 눈사람을 파괴할 수 있다면 동물을 학대할 수 있고 마침내 폭력은 자신을 향할 거라는 공포도 입에 담지 않았다. 단지 둘의 사이가 더 깊어지기 전에 큰눈이 와주었던 게 어쩌면 다행이었단 생각이 들 뿐이었다.

- 이적의 인스타그램에서 발췌

5. AI 윤리문제

...라기엔 이 문제가 너무 어설퍼서, 딱히 흥미는 없어. 이루다는 애초에 AI 윤리까지 고민할 능력도 의지도 없었던 것 같아. 한시간 정도 써 보니, 필터링의 개념에서 벗어나지 않더라구. 이루다의 선례인 심심이도 마찬가지야. 서비스한 지 10년도 넘었다는데, 면피하는 수준으로 서비스 윤리를 생각하고 있지. AI의 윤리 개념을 실무적으로 고민하는 회사가 있긴 있을까?

★ 심심이가 나를/누군가를 위협해요.

앞에서 설명한 대로 누군가가 입력해 놓은 말을 심심이가 그대로 하는 것 뿐 입니다. 말풍선을 터치해 신고해 주세요.

★ 심심이가 개인정보에 관한 말을 해요.

나쁜말과 마찬가지로 누군가가 입력한 내용을 심심이가 그대로 말을 한 것입니다. 심심이가 나의 정보 혹은 다른사람을 정보를 말하면 말풍선을 터치하여 신고하거나 앱내 "이메일 보내기" 메뉴를 통해 신고해 주세요.

- 어떻게든 책임을 지고 싶지 않은 심심이 앱 설명, 구글플레이에서 발췌

하지만, 어쨌든 앞으로 UX 관점에서의 윤리문제는 계속 더 미묘해지고 다양해질 텐데, 이런 시행착오의 데이터가 너무나 무의미한 수준이라서, 나 같은 비-개발자는 로켓을 만들기는 커녕 군불도 지피지 못할 것 같아. 게다가, 인터넷에서 발견할 수 있는 AI 윤리에 대한 담론들이 너무 뜬구름 잡는 거 같아서, 불안해. 갑자기 미래가 훅 들어오면 어떡하지?

'ZEN of UX' 카테고리의 다른 글

| ZEN of UX. 09 - Tab에 대한 단상 (1) (1) | 2021.02.07 |

|---|---|

| ZEN of UX. 08 - 모서리가 둥근 사각형은 왜 사용하는가. (12) | 2021.01.18 |

| ZEN of UX. 06 - 디자인을 잘하기 위한 사소한 습관 만들기 - UX, UI, GUI (2) | 2021.01.09 |

| ZEN of UX. 05 - 우리는 언제 Blur를 사용해야 할까. (0) | 2021.01.06 |

| ZEN of UX. 04 - 디자인을 위한 줄바꿈 테스트 - 중앙일보와 KBS를 개편하며 실험하기 (1) | 2021.01.05 |